海底撈的小哥們,爲了科目三,崴了多少腳。

但是千算萬算,沒有算到在通義千問悄悄上線的“全民舞王”的助攻下,只需要一張照片,人人都可以科目三。

以現在大模型的“姿勢水平”,文字生成文字,文字生成圖片對它而言已經變成了“小兒科”,不管大家在排行榜上競爭得如何激烈,真正的競爭,其實已經到了跨模態生成領域——“全民舞王”的圖片生成視頻是這樣,讓馬斯克和紮克伯格等知名外國人在視頻裏說中文也是這樣。

而且,“全民舞王”依托的Animate Anyone大模型,已經不止停留在“玩具”層面上。結合阿裏雲最新的Outfit Anyone“一鍵試衣”大模型,未來我們在淘寶買衣服,上傳一張照片就能看到動態的上身效果視頻,已經不再遙遠。

阿裏心心念念的“AI電商”,如今又多了一張拼圖。

國外已經火了三個月科目三之所以成爲“現象級”舞蹈,並不是因爲它在國內短視頻平台有多麽“火”,因爲五六年前的社會搖已經做到了這一點——而是它能不能成爲文化輸出的一個符號,進而獲得登堂入室的門票。

單論結果,科目三現在早就走出了短視頻平台,還被做進了遊戲,走上了國際化大舞台。

譬如在去年12月9日的世界體育舞蹈大賽上,世界冠軍克裏斯蒂娜和幾位舞者一起展示了國標版“科目三”;騰訊上線剛一個月的“正版合家歡派對遊戲”《元夢之星》裏面,老壺也發現了角色專屬的“科目三”表情動作。

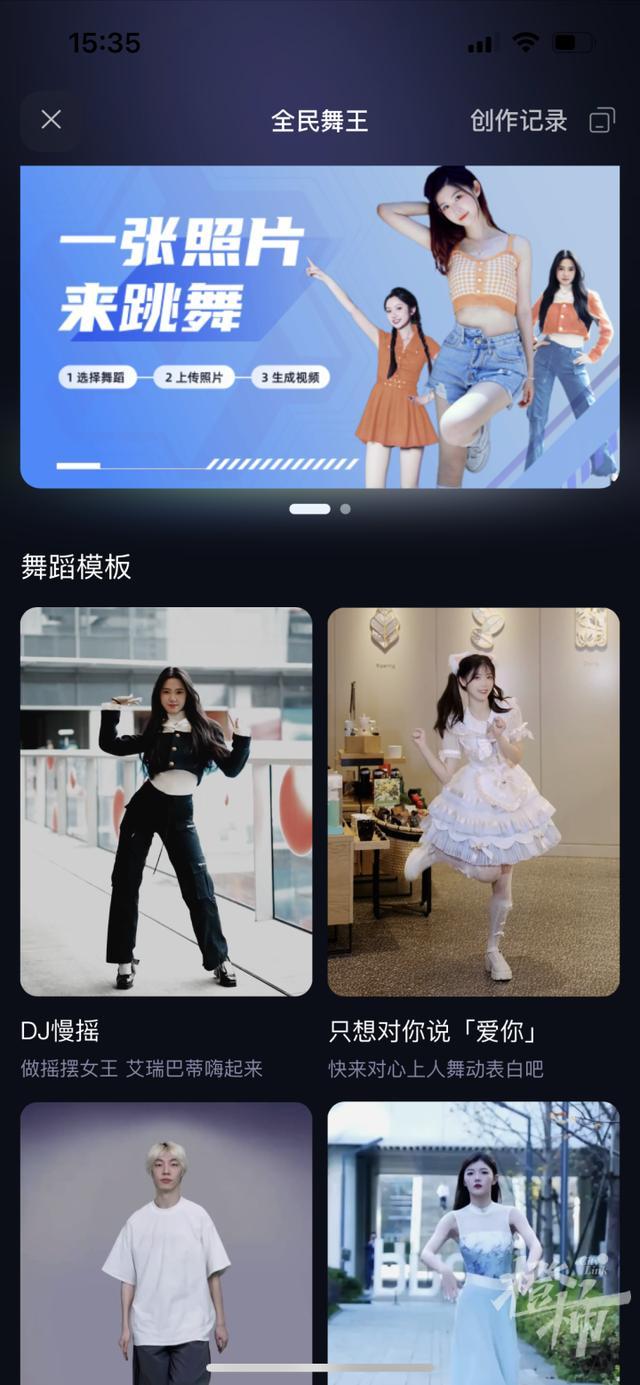

再到如今的“全能舞王”,只需在通義千問app裏面上傳一張全身照片,再等待10分鍾左右,就能生成一段10秒左右的跳舞短視頻。

進入“全民舞王”的模板區,有DJ慢搖、只想對你說“愛你”、鬼步舞、蒙古舞、科目三、劃槳步等12種熱門舞蹈的模塊可以選。雖然可以選的有很多,但就流量和關注度而言,科目三自然是毫無疑問的C位。

捋一捋時間線也能發現,國外短視頻達人開始“病毒式傳播”科目三的時間點,恰好是在去年10-11月份左右。差不多在同一時期,阿裏雲旗下團隊就發布了“全能舞王”相關的大模型技術文檔。

要知道,科目三這個舞種不同于一般手勢舞,是需要一定的舞蹈基礎和四肢協調性的。換句話說,在國外也並非所有人都能輕松駕馭。

但阿裏雲發布的這篇論文,則通過“Animate Anyone”的模型,將固定的角色圖像轉化爲特定姿勢序列控制的動畫視頻,換句話說,之前一點舞蹈基礎都沒有的人,現在可以通過這個模型,開局只需一張圖,就能爲所有舞蹈小白,提供了在短視頻領域“走上舞台”的可能。

也因此,這條介紹“Animate Anyone”的推文在發布不到一個月,就斬獲了超過5000萬的點擊,也就不足爲奇了。

在 “ Animate Anyone ”出現之前,從靜態圖像到動態視頻的合成,仍然有很多“坎”需要過,

首先是細節一致性。

舉個例子就是,現在市面上的AI圖片或者文字生成視頻,很多時候主體之外的圖像會出現局部變形、細節模糊和幀數不可控的問題,這些都會影響視頻生成的質量。

再比如動作控制和連貫性。因爲視頻如果要商用,視頻裏人物的動作是需要保證可控性的。如果是AI生成,則主要通過預先輸入的動作序列來控制角色動作。但在目前AI視頻的角色動作,還無法完全靠prompt精准控制。

在圖片生成文字的過程中,還需處理的是圖像到視頻的轉換過程,並且需要保證這個過程中,圖像的空間與時間一致性。

在此之前,諸如stable Diffusion、midjourney等AIGC産品雖然已經初步具備了文生圖和圖生圖、圖生視頻等跨模態生成能力,但在AI生成視頻領域,前面提到的問題仍然沒有得到解決。

“Animate Anyone”則在很大程度上,對前述相關問題作出了改進。首先團隊通過名爲“ReferenceNet”的輔助模型,用來捕捉參考圖像的空間細節,這保證了角色每一幀外觀細節的一致性;

其次,團隊使用了一種高效的Pose Guider姿態引導器,這讓角色的運動姿勢得到了有效控制,體現在視頻中,則是讓視頻角色按設定好的姿勢進行運動,並具備穩定的過渡,保證連續性和流暢性;

此前AI生成的視頻細節爲何不可控,很大程度上是因爲每一幀的時間關系不夠緊密,很多細節沒辦法保留到下一幀。在“Animate Anyone”的模型裏,則通過一個時序生成模塊來保證多個視頻幀之間的關系,很多高分辨率的細節得以全程保留。

即便是解決了這麽多技術難題,單看目前“全能舞王”的生成效果,也與真人上鏡有一定的差距。譬如生成的舞蹈節奏是平均的,但現實音樂大多數都是快慢分布。這讓“科目三”的生成效果不可避免打了折扣。

但與一衆大模型前輩相比,“Animate Anyone”已經把最重要的形象一致性和姿態穩定、多幀關系控制等關鍵問題搞定,在圖生視頻賽道上,已經完成10-60+分的突破。

AI電商的另一塊拼圖?圖生視頻從10分到60分,意味著什麽?

意味著它不僅可以完整保留人臉、身材比例、服裝細節和背景信息,同時還能對生成的動作做精准控制,且在技術上生成的視頻長度不受限制。與Gen2、Pika等文本生成視頻的産品比, AnimateAnyone更聚焦人本身。

也就是說,起碼在圖生視頻這一塊,“Animate Anyone”已經將AI視頻從“玩具”變成了“可初步商用”。再加上阿裏近期發布的“Outfit Anyone”,用戶可以僅僅用服飾的平鋪圖,就可以實現上下裝的試穿。

如果與二者結合。用戶不僅可以通過上傳一張照片,試穿自己心儀的大多數服裝,而且可以通過動態動畫,直接預覽它的上身效果。與其說淘寶模特因爲AI失業,不如說AI讓所有人都可以成爲自己的模特。

當然,“Animate Anyone”能夠應用的地方也不止于此,很多遊戲開發人員大可使用這種算法,將靜態的遊戲角色圖像轉換爲具有不同動作和姿勢的動畫角色,以此實現同一款素材的多次複用,並增加對應角色的沉浸感和可信度。

而大家在淘寶買東西,最怕的是什麽?就是“賣家秀”和“買家秀”的差異所帶來的低可信度。但在自己的AI化身成爲淘寶模特之後,這個顧慮很大程度上會被打消,交易中最重要的信任成本也因此消失。

還記得在拼多多市值剛剛超越阿裏巴巴的時候,馬雲老師除了表示對拼多多的祝賀,還專門提到了“AI電商”的概念:“AI電商時代剛剛開始,對誰都是機會,也是挑戰。”

在價格和交易環節,它可能是基于AI驅動的實時比價,助力消費者買到自己最心儀的産品;在服務和體驗環節,它有可能是更優質的數字人售後和更身臨其境的購物體驗。

能替用戶試穿衣服的“AI模特”不過只是服裝品類體驗的一小步,但就整個阿裏AI電商的戰略而言,它可能是無數基礎拼圖的其中一塊,但也是極爲重要的一塊。