2023年9月,OpenAI發布了多模態大模型GPT-4V,開啓了多模態研究熱潮。短短8個月時間內,閉源模型如Gemini系列, Qwen-VL-Max,開源模型如Mini-Gemini, LLaVA-NeXT百花齊放。

然而,在多模態大模型領域,閉源和開源模型依然存在著明顯的鴻溝。

開源模型能否在性能上和閉源模型並肩?

又要如何才能做到這一點?

GPT-3.5研究測試:https://hujiaoai.cn

GPT-4研究測試:https://higpt4.cn

Claude-3研究測試(全面吊打GPT-4):https://hiclaude3.com

來自上海人工智能實驗室、商湯科技研究院、清華大學等的研究者們發布了他們的答案——開源多模態大模型InternVL 1.5。

在18項主流基准中,InternVL 1.5在其中8項中達到sota!實驗結果表明,InternVL 1.5已經有了與領先的閉源模型相媲美的水准。

論文標題:How Far Are We to GPT-4V? Closing the Gap to Commercial Multimodal Models with Open-Source Suites

論文鏈接:https://arxiv.org/pdf/2404.16821

模型演示:https://internvl.opengvlab.com/

爲什麽閉源和開源多模態大模型會存在差距?研究者們首先對目前開源與閉源(專有商用)的多模態大模型(MLLM)展開了調研。他們發現,兩者的差距主要體現在三個方面:

(1)圖像分辨率:專有商用模型通常采用動態分辨率方法,保留原始縱橫比,以方便詳細的場景和文檔理解。相比之下,開源模型通常以固定分辨率進行訓練,如336×336 和 448×448,導致能力相對于商用同行有相當大的差距。

(2)參數規模:近期專有商用的MLLM通常規模不少于 1000 億參數,而開源模型通常采用 3 億參數的視覺基礎模型 (VFM),該模型與 70 億或 130 億個 LLM 集成。

(3)多語言能力:專有商用模型通常利用廣泛的多語言數據集進行訓練,從而提高其在不同語言上的性能。然而,開源模型主要利用英語數據,依賴于其他語言的LLM的零樣本(Zero-shot)能力,例如 LLaVA-NeXT。這會導致其在非英語場景理解和 OCR 任務中的性能不佳。

爲了彌補這些差距,針對上述三個問題,InternVL 1.5集成了三項重大改進,增強了模型的性能和可用性,如下圖所示。

(1)動態高分辨率:我們采用動態高分辨率策略,將圖像分割成 448×448 的圖塊,根據圖像的長寬比和分辨率,圖塊數量從 1 到 40(即 4K 分辨率)不等。爲了捕獲全局上下文,我們還添加了縮略圖視圖。

(2)強視覺編碼器:我們爲大規模視覺基礎模型 InternViT-6B 探索了一種持續學習策略,提高了其視覺理解能力,並使其可以在不同的LLM中遷移和重用。另外,使用 InternLM2-20B 作爲語言基礎模型,提供強大的初始語言處理能力。

(3)高質量的雙語數據集:我們精心收集了高質量的雙語數據集,涵蓋常見場景、文檔圖像,並用英文和中文問答對對其進行標注,顯著提高了 OCR 和中文相關任務的性能。

模型細節下面我們將對上述三項改進做簡單的展開。

整體架構首先是整體架構方面,InternVL 1.5采用與流行的MLLM類似的ViT-MLP-LLM架構,通過 MLP 結合預先訓練的 InternViT-6B 與 InternLM2-20B。在這裏,我們采用簡單的 Pixel Shuffle 將 visual tokens 的數量減少到四分之一。

動態高分辨率

動態高分辨率我們采用動態高分辨率訓練方法,可以有效地適應輸入圖像的不同分辨率和長寬比。該方法利用將圖像分割成圖塊的靈活性,增強模型處理詳細視覺信息的能力,同時適應不同的圖像分辨率。

該方法主要由兩個步驟組成:

(1)動態縱橫比匹配。如下圖所示,爲了在處理過程中保持自然的寬高比,我們從一組預定義的寬高比(共35種)中動態匹配最佳的寬高比。由于計算資源有限,我們在訓練期間最多允許 12 個圖塊。

(2)圖像分割和縮略圖。一旦確定了適當的寬高比,圖像的大小就會調整爲相應的分辨率。例如,800×1300 圖像將調整爲 896×1344。然後將調整大小的圖像分爲 448×448 的圖塊。除了圖塊之外,我們還包含整個圖像的縮略圖以捕獲全局上下文,該縮略圖縮小至 448×448。因此,在訓練過程中,visual tokens的數量範圍爲 256 到 3,328。在測試過程中,圖塊數量最多可以增加到 40 個,從而産生 10,496 個visual tokens。

強視覺編碼器

強視覺編碼器在選擇更強的視覺編碼器方面,我們對 InternViT-6B 模型進行了持續預訓練。

我們發現倒數第四層的特征對于多模態任務表現最好,因此我們直接丟棄最後三層的權重,將 InternViT-6B 從48層減少到45層。然後,我們將 InternViT-6B 的分辨率從224提高到448,並將其與 Nous-Hermes-2-Yi-34B 集成。利用 圖像字幕組合 和 OCR 數據集,模型的視覺編碼器和 MLP 都被激活進行訓練。

基于上述過程,我們得到了新的模型 InternViT-6B-448px-V1.2。

InternVL 1.5 的訓練基于 InternViT-6B-448px-V1.2 進行。在本次更新中,訓練圖像的分辨率從固定的 448×448 擴展到動態 448×448,其中基本圖塊尺寸爲 448×448,圖塊數量從1到12。此外,我們增強了預訓練數據集的數據規模、質量和多樣性,從而使我們的1.5版本具有強大的魯棒性、OCR能力和高分辨率處理能力。

值得注意的是,盡管 InternVL 1.5 中的 LLM 從 Nous-Hermes-2-Yi-34B 更改爲InternLM2-20B,InternViT 與新的 LLM 保持了良好的兼容性和可移植性。這表明 InternViT-6B 在 MLLM 預訓練階段學到的視覺特征具有廣泛的適用性,並且與特定的 LLM 沒有緊密聯系。

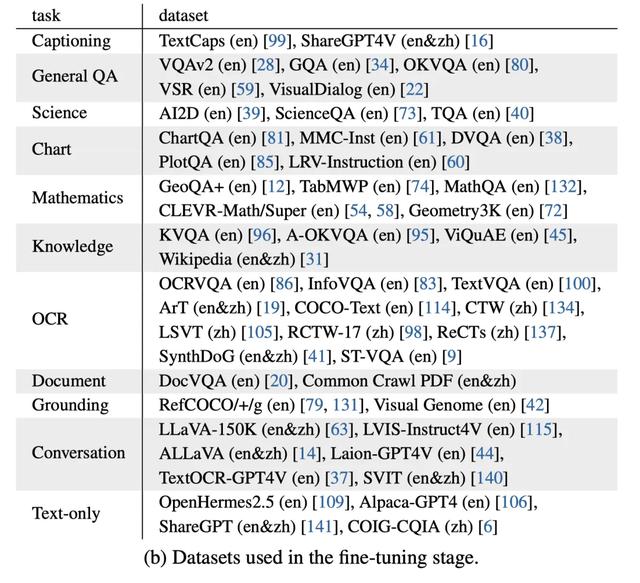

高質量的雙語數據集數據集方面,我們列舉了自己在預訓練和微調階段選擇的數據集。預訓練階段,主要關注各種可公開訪問的數據源。在微調階段,則通過精心選擇的數據集,增強了模型在各種多模態任務中的性能。

同時,爲了增強模型的多語言能力,我們實現了數據翻譯pipeline,利用最先進的開源LLM或GPT-3.5 將英文數據集轉換爲另一種語言(例如中文),保持雙語標注的一致性和准確性。在下表中,用括號注釋了數據集所使用的語言。

模型性能評測

模型性能評測最後,我們對 InternVL 1.5 進行了全方位的評測,以評估我們模型的多模態理解和推理能力。

我們研究中使用的基准分爲四種不同的類型:OCR 相關基准、通用多模態基准、數學基准和多輪對話基准。如下表所示,與開源和專有商業模型相比,InternVL 1.5 顯示出具有競爭力的性能,在 18 個多模態基准測試中的 8 個中取得了sota的結果。

其中,InternVL 1.5 在OCR相關基准、數學領域和其他通用多模態基准中,表現遠超其他開源模型,與商用模型性能相當;並展現出強大的中文能力。

但在多輪對話領域,盡管 InternVL 在開源模型中依然領先,仍落後于 GPT-4V。展望未來,我們將繼續完善 InternVL 在多輪對話中的功能。

總結

總結通過對傳統開源多模態大模型的全方位升級,InternVL 1.5 邁出了具有建設性的一步。

更高的分辨率、更強的視覺編碼器、更高質量的數據集,使 InternVL 1.5 得以在 18 個多模態基准測試中的 8 個中取得了sota的結果,具備了與閉源商用多模態大模型相當的性能。

我們非常期待開源多模態大模型能夠取得更高的成就,讓通用人工智能領域的普及更進一步!