引言

在統計學與機器學習的遼闊天地中,線性回歸猶如一顆璀璨的明珠,它以簡潔而強大的建模力量,構築起自變量與因變量之間的橋梁。而多元線性回歸,作爲線性回歸的華麗變奏,它拓展了視野,允許多個自變量共同舞蹈,共同影響因變量的節奏。在Python的天地裏,有了NumPy、pandas和scikit-learn這些得力助手,多元線性回歸的實現變得遊刃有余。本文旨在深入探討Python中多元線性回歸的藝術,結合實例編程,引領讀者全方位掌握其原理與操作。

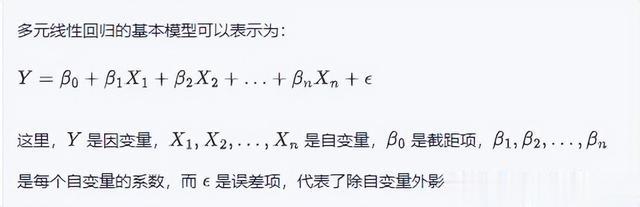

多元線性回歸概述

實現多元線性回歸之路

數據准備在踏上多元線性回歸之旅前,數據的收集與整理是首要任務。所需數據應包含衆多個自變量及一個因變量,通常以二維表格形式呈現,行代表樣本,列代表特征。

數據集分割爲公正評價模型的性能,需將數據集一分爲二,劃分爲訓練集與測試集。訓練集用以模型的鍛造,而測試集則用于檢驗模型的預測能力。常見做法是,訓練集占據八成,余下兩成留給測試集。

模型訓練借助訓練集的滋養,scikit-learn庫中的LinearRegression類將自動擬合模型,探尋那組最優的系數。

模型評估訓練完畢後,模型需在測試集上接受考驗。均方誤差(MSE)是衡量模型預測准確性的重要指標,誤差越小,模型性能越優良。

模型應用經過嚴格訓練與評估,模型終將展翅高飛,應用于新數據的預測。只需輸入自變量,模型便能預測出因變量的值,爲現實世界的問題提供解答。

實際編程演練 接下來,讓我們以房屋價格預測爲例,一探在Python中實現多元線性回歸的奧妙。

import numpy as npimport pandas as pdfrom sklearn.model_selection import train_test_splitfrom sklearn.linear_model import LinearRegressionfrom sklearn.metrics import mean_squared_error# 數據准備data = { 'Area': [1200, 1500, 1800, 2000, 1000], 'Bedrooms': [2, 3, 3, 4, 2], 'Distance_to_center': [5, 4, 3, 2, 6], 'Price': [300000, 400000, 500000, 550000, 250000]}df = pd.DataFrame(data)# 自變量與因變量分離X = df.drop('Price', axis=1)y = df['Price']# 數據集分割X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# 模型訓練model = LinearRegression()model.fit(X_train, y_train)# 模型評估y_pred = model.predict(X_test)mse = mean_squared_error(y_test, y_pred)print("均方誤差:", mse)# 模型應用new_data = { 'Area': [1600], 'Bedrooms': [3], 'Distance_to_center': [4]}new_df = pd.DataFrame(new_data)predicted_price = model.predict(new_df)print("預測價格:", predicted_price)結論

多元線性回歸,這一強大的統計分析工具,不僅搭建起多自變量與因變量之間的線性橋梁,更通過Python中的各類庫,讓我們能夠輕松地進行分析與預測。在實際應用中,我們應注重數據的預處理、模型的訓練與驗證,確保所得模型的准確性與可靠性。願本文能成爲您在Python世界中探索多元線性回歸的指南,助您理解和運用這一技術。